Résumé du Projet

Ce projet de master 1, intitulé “La vie multilingue des mots sur le web”, se concentre sur le syntagme “discrimination raciale”. L’objectif était de constituer des corpus web en français, anglais et chinois pour analyser, via des méthodes de traitement automatique des langues (TAL), les contextes et cooccurrences de ce terme. Les résultats sont présentés sur un site web dédié, démontrant un cycle de projet complet, de la collecte de données brutes à la visualisation interactive.

Mon Rôle et Contributions

En tant que chef de projet, j’ai supervisé l’ensemble du cycle de vie du projet. Mes responsabilités principales incluaient :

- Développement Backend et Scripting : J’ai conçu et écrit les scripts shell (

bash,zsh) pour automatiser la collecte de données (aspiration web aveccurl) et le prétraitement des corpus. - Traitement Spécifique au Chinois : J’ai développé des scripts Python utilisant la librairie

jiebapour la segmentation des mots chinois, un défi technique majeur en raison de l’absence d’espaces. J’ai également géré le nettoyage des données et la suppression des mots vides. - Développement Frontend : J’ai construit le site web de présentation des résultats de A à Z en utilisant le framework Astro, avec HTML5, CSS3 et Bootstrap pour une conception responsive.

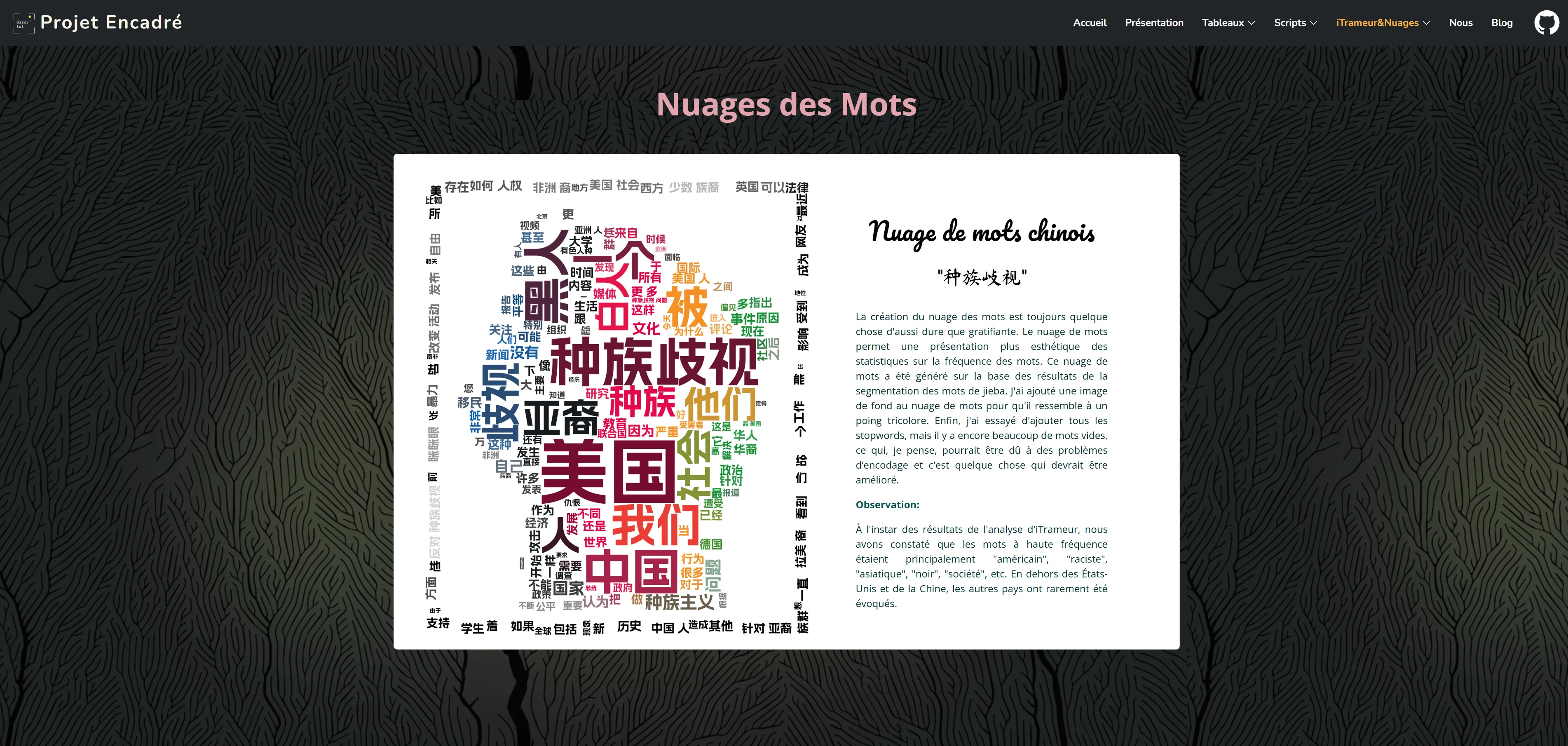

- Analyse de Données et Visualisation : J’ai utilisé des outils comme iTrameur pour réaliser des analyses quantitatives (fréquences, cooccurrences, segments répétés) et créé des visualisations (nuages de mots) avec WordCloud en Python pour interpréter les résultats.

Démarche Technique

Le projet a suivi plusieurs étapes techniques clés :

- Constitution du Corpus : Des scripts automatisés ont été créés pour scraper des articles de presse, des forums et des blogs pertinents dans les trois langues cibles.

- Prétraitement des Données : Les textes ont été nettoyés et normalisés. Pour le corpus chinois, un dictionnaire personnalisé a été élaboré pour affiner la segmentation par

jieba, afin de préserver les balises structurelles nécessaires à l’analyse. - Analyse Quantitative : Nous avons calculé des métriques linguistiques pour comparer les usages :

- Fréquence des termes : Identification des mots les plus associés à la “discrimination raciale”.

- Analyse des Cooccurrences : Étude des mots qui apparaissent fréquemment aux côtés de notre terme cible pour révéler les contextes dominants.

- Segments Répétés : Mise en évidence des expressions et des constructions phraséologiques récurrentes.

Principales Conclusions de l’Analyse

L’analyse comparative des trois corpus a révélé des spécificités culturelles et médiatiques notables :

- Dans le corpus chinois, le discours sur la “discrimination raciale” est très souvent lié aux États-Unis, avec une forte mention des communautés noires et asiatiques. Les termes cooccurrents comme “s’opposer” (反对) et “éliminer” (消除) indiquent une posture critique et prescriptive des médias.

- L’analyse a montré que si le sujet est universel, les acteurs, les victimes et les angles de discussion varient considérablement d’une langue à l’autre, reflétant les contextes socio-politiques de chaque sphère linguistique.

Défis et Solutions

Le principal défi technique a été le traitement du corpus chinois, notamment la segmentation des mots avec jieba tout en préservant les balises XML pour iTrameur. La solution a impliqué une modification des scripts pour pré-traiter les balises avant la segmentation, puis les réinsérer, garantissant ainsi l’intégrité des données pour l’analyse.

Ce projet a été une excellente application pratique des concepts du TAL, combinant des compétences en programmation, en analyse linguistique et en développement web.